在这个AI浪潮席卷全球的时代,GPU云服务器已经成为推动技术创新和业务增长的核心动力。无论你是AI开发者、独立站卖家,还是企业IT决策者,都能从GPU云计算的最新变革中受益。数据显示,到2025年,全球GPU云服务器市场规模预计将突破23亿美元,年复合增速接近20%。这背后的核心驱动力,正是AI大模型训练、推理和数据密集型应用的需求激增。

很多用户会问,GPU服务器不是已经用了很多年了吗?为什么最近又被频繁提及?其实,这一轮行业升级,正好踩在了硬件创新和AI专用架构演变的交汇点上。你如果能提前了解趋势,就能更早抓住高性能计算红利,让自己的项目如虎添翼。

硬件升级:从“通用GPU”到“AI专用芯片”

当我们提到GPU云服务器,过去几年基本就是Nvidia的天下。然而,2025年将成为分水岭,Nvidia Blackwell、AMD MI350、AWS Trainium2等新一代AI专用硬件接连亮相,各有亮点。

| 芯片/架构 | 峰值算力 | HBM内存 | 上市时间 | 优势解读 |

|---|---|---|---|---|

| Nvidia Blackwell B200 | 20 PFLOPS FP4 | 192 GB HBM3e | 2025量产 | 单板性能大幅提升,适合大规模AI训练 |

| AMD MI350 | 推理性能提升35× | 288 GB HBM3e | 2025 | 支持FP4/FP6混合精度,兼容性出色 |

| AWS Trainium2 | 650 TFLOPS BF16 | 96 GB HBM3e | 2024-2025上线 | 定制AI芯片,性价比高,适合推理和混合任务 |

| Google TPU v5e | 197 TFLOPS BF16 | 16 GB HBM2 | 2025 | 按需弹性扩展,主打超大规模推理 |

行业变化我怎么看?

- 算力指数级提升:以Blackwell为例,采用了Chip-to-Chip互联和更高带宽HBM,单卡推理能力达到20 PFLOPS。AI训练与推理的门槛再一次被拉低。

- AI专用芯片崛起:AWS、Google纷纷推自研AI芯片,摆脱对单一GPU品牌依赖。Trainium2、TPU等更适合特定AI负载,性价比优势明显。

- 精度下沉带来成本优化:FP4、FP8等低精度计算被各家硬件普遍支持,推理成本最高可降一半以上。

- 更强扩展能力:新一代芯片普遍支持更高容量的HBM内存和多卡互联,千亿参数模型也能轻松上云。

云服务形态进化:弹性、切片、多样化套餐

如果你用过早期GPU云服务,肯定遇到过“高配难租”“资源浪费”“按月计费不灵活”等痛点。而在2025年,这些问题正被新一代产品形态逐步化解。

多实例GPU(MIG)技术

Nvidia在Blackwell系列上将MIG技术做到极致——单张GPU最多可切分为7个互相独立的小实例,每个实例都有独享的资源。对于AI推理、小批量训练甚至短时爆发需求来说,极大地提升了资源利用率和灵活性。

弹性云集群与Serverless模式

- 超大集群:像AWS的Trainium2 Ultra、Google TPU v5e Pod,云端可扩展到上百颗芯片协同工作,满足大模型训练。

- Serverless推理:你无需提前预约GPU资源,直接按调用次数或token数量计费,更适合不确定性高的AI应用场景。

- Spot实例:闲置GPU通过Spot市场低价出售,成本可降至按需3-5折。

按秒计费成为主流

和传统的“包月包年”不同,按秒计费让你的成本更可控。短时实验、灵活弹性扩容,都能轻松应对。

选择GPU云服务器:我的建议与Hostease优势

说到实际应用,无论你是初创AI团队还是独立站卖家,选择GPU云服务器最看重什么?我的经验是:性能、价格、地域和易用性缺一不可。

Hostease的优势在哪里?

- 硬件同步全球主流:2025年会率先上线Blackwell、MI350等旗舰GPU,跟上全球AI算力步伐。

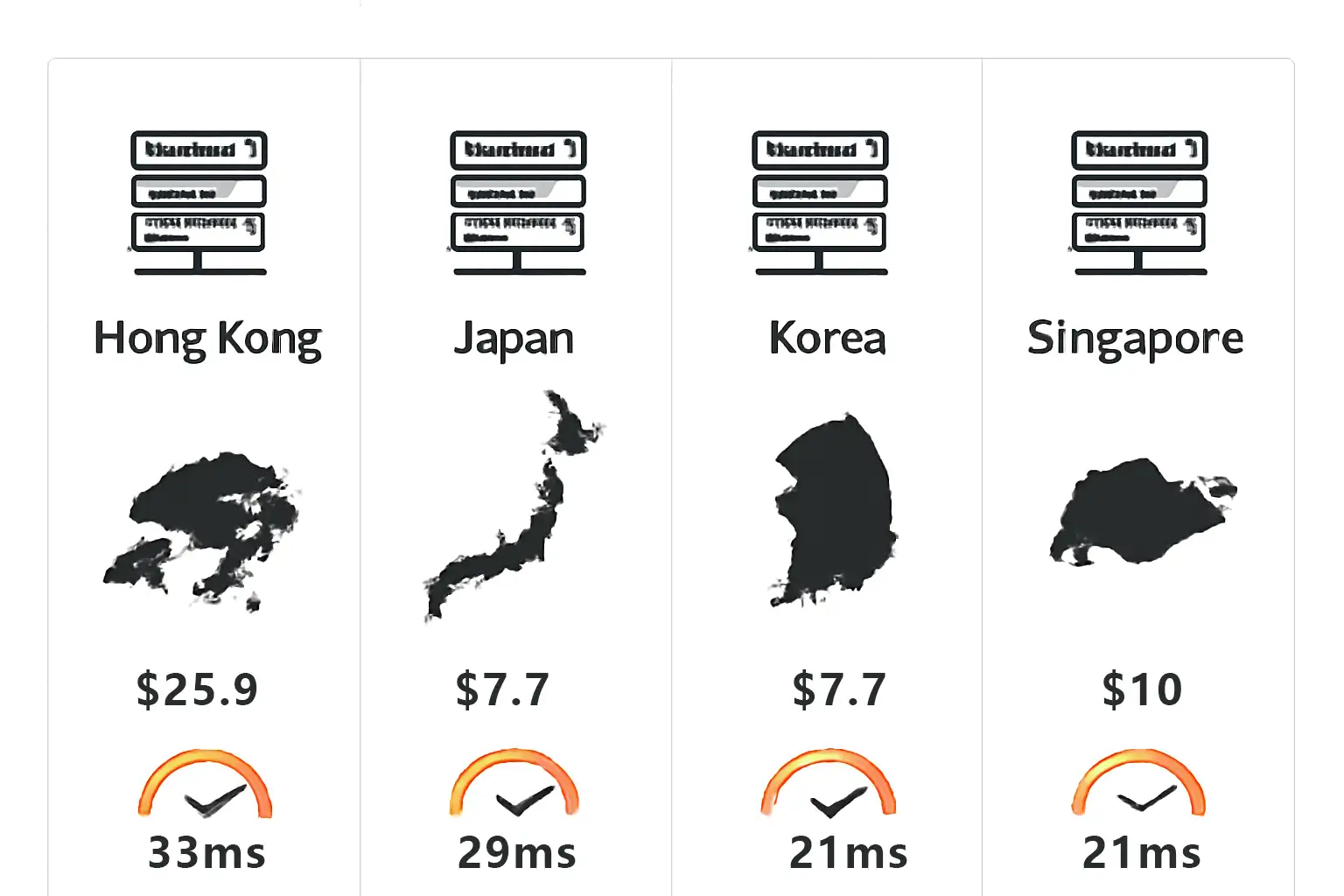

- 多地区低延迟:香港、洛杉矶数据中心直连高速专线,面向亚太及北美用户都很友好。

- 灵活计费,省钱更省心:支持按秒、按需、Spot多种计费,既能抢占训练高峰,也能低价推理运维。

- 开箱即用的AI环境:内置CUDA、ROCm、Neuron SDK等主流开发环境,无需复杂配置,10分钟上线。

- 服务保障:Hostease提前锁定服务器产能,支持预约测试新一代GPU,保障资源稳定供应。

温馨提醒: 如果你对新一代GPU(比如Blackwell/MI350)感兴趣,建议提前预约Hostease测试位。这样既能抢先体验硬件红利,也有机会享受早鸟优惠!

常见问题FAQ

Q:我怎么判断用Blackwell、MI350还是Trainium2?

A:Nvidia Blackwell适合需要社区生态和复杂模型的用户;追求性价比、推理为主时AWS Trainium2是不错选择;如果要做低精度混合训练,AMD MI350表现也很突出。

Q:GPU多实例(MIG)会不会影响性能?

A:理论上,MIG划分后每个实例都有独立资源。实际测试延迟仅增加3%-5%,但能大幅降低使用成本,非常适合AI推理或中小规模训练。

Q:GPU资源紧张怎么办?

A:Hostease采用“预约+Spot”策略,提前锁定Blackwell等主流GPU资源,并保证弹性调度。遇到高峰时也能优先获得资源。

Q:Google TPU能在Hostease用吗?

A:目前TPU仅在Google Cloud原生支持,但Hostease正在推进混合云直连,未来有望在自家平台体验TPU资源。

写在最后:现在就是布局AI云的好时机

2025年将是GPU云服务器行业飞跃的一年。无论是硬件进化、云服务产品升级,还是成本与体验的优化,对你而言都是实实在在的利好。现在就访问Hostease官网,预约你的专属高性能GPU云服务器,拥抱AI专用架构的新时代,把握每一次创新机会!