如果你是独立站卖家、AI应用创业者或数据团队负责人,正在云上做图像分类、NLP微调或多区域低延迟部署,那么选对GPU服务器能直接影响训练时长与每月账单。我们用“你能听懂的方式”对比A100、V100、T4、3090在GPU云服务器上的真实差异,并结合价格性能比给出选型建议。

我们如何评测与对齐口径

深度学习最有用的指标不是理论TFLOPS,而是训练吞吐量(images/s、tokens/s);吞吐量越高,完成同一训练目标所需时间越短。Lambda的公开基准采用PyTorch/NGC容器,按模型类型报告单/多卡训练吞吐量,我们据此汇总“相对速度”和“训练时间倍数”。

同时,我们引用Dell基于MLPerf的对比来刻画T4与V100在实际“收敛到目标精度”的训练时间差,这能更接近你的真实等待成本。

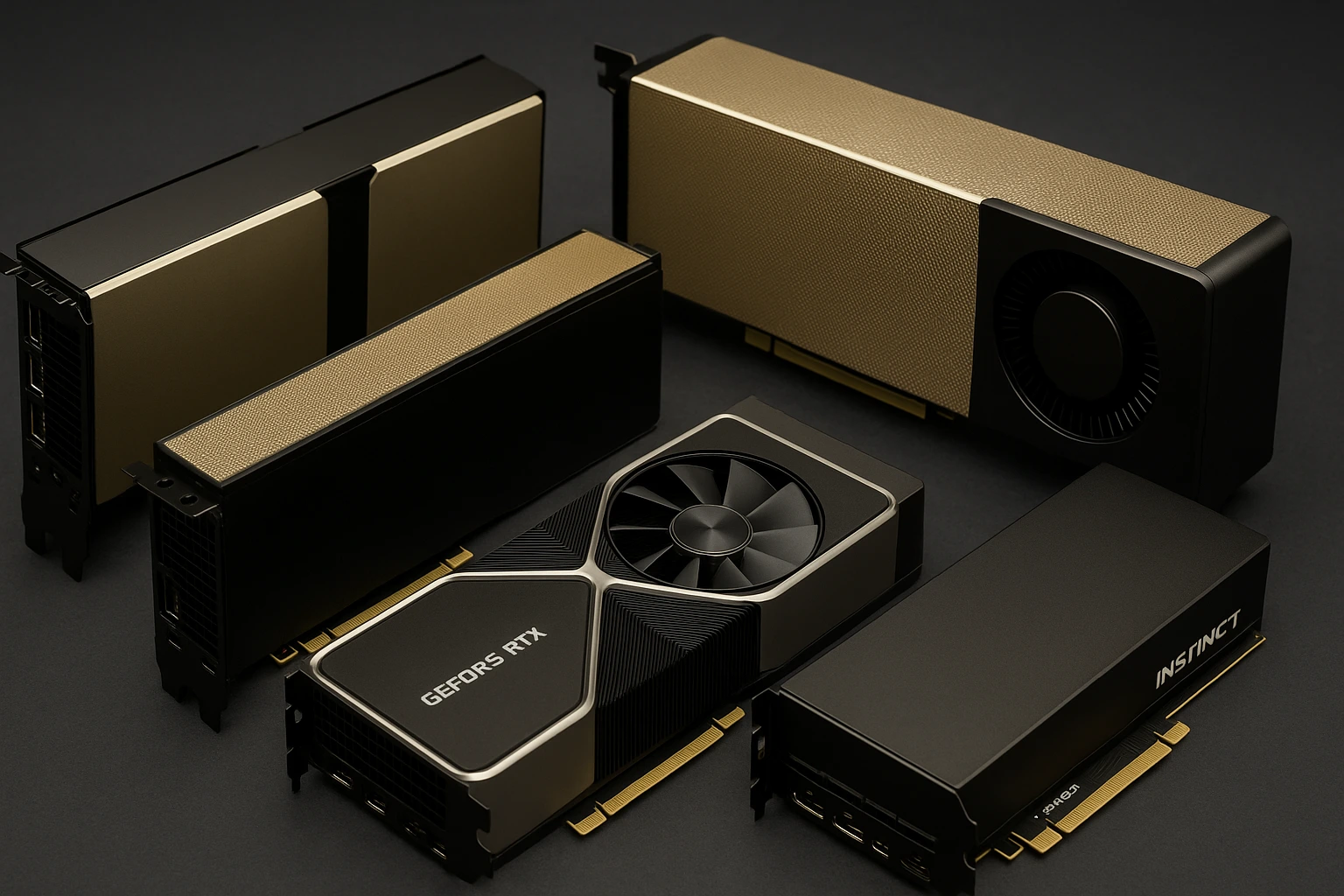

核心规格参数一览(便于快速筛选)

规格用于理解“为什么会快/慢”,实际训练速度请结合下一节的跑分结论。

| GPU | 显存 | 显存带宽 | 典型张量性能(半精度) | FP32峰值 | 功耗TDP | 备注 |

|---|---|---|---|---|---|---|

| A100(40/80GB) | 40/80GB HBM2 | 1.6TB/s(40GB)、2.0TB/s(80GB) | FP16 Tensor Core≈312TFLOPS | 19.5TFLOPS | 300-400W | 支持TF32、MIG分割实例,训练/推理皆强 |

| V100(16/32GB) | 16/32GB HBM2 | ≈900GB/s | FP16 Tensor Core≈125TFLOPS | 15.7TFLOPS | 250-300W | 经典数据中心卡,老牌稳定 |

| T4(16GB) | 16GB GDDR6 | ≈320GB/s | FP16≈65TFLOPS | 8.1TFLOPS | 70W | 低功耗、偏推理/轻量训练 |

| RTX3090(24GB) | 24GB GDDR6X | ≈936GB/s | 第3代Tensor Core | — | 350W | 消费级单卡性价比高,显存充裕 |

跑分结论与训练时间对比(以相对倍数呈现)

为了让你快速做决策,我们汇总了来自公开基准的“相对速度”和推导出的“训练时间倍数”(时间≈1/速度)。不同任务/实现可能有偏差,但方向一致。

- A100 vs V100:在语言模型训练中,A100使用FP16/TF32通常比V100快约1.95×~2.5×;也就是说,同样目标下训练时间可降到V100的40%~51%。

- 3090 vs A6000(便于理解3090定位):单卡卷积网络训练,RTX A6000≈**1.01×**RTX3090(几乎持平);语言模型训练,RTX A6000≈**1.34×**RTX3090,说明3090在NLP大batch时更易受显存/带宽限制。

小结:纯训练速度A100≫V100≫3090≈A6000(卷积类)≫T4;NLP大模型更偏爱数据中心卡(A100/V100),3090在NLP上相对吃力一些。

价格与价格性能比:按小时成本算得更清楚

实际选型绕不开“每小时多少钱、每张卡能跑多快”。TensorDock公开了统一环境下的相对训练速度与按小时价格,能直接看“训练速度/美元”。要点如下:

- 训练速度/美元:A100、H100在原始速度上最佳;若只看每美元的训练速度,24GB的RTX4090/3090、L40/RTX6000 Ada在小中型模型上往往更划算。

- 按小时价格示例(平台自报价,随时会变动,用于相对比较):A100 80GB约**$1.63~$1.65/小时**、V100 32GB约**$0.42/小时**、RTX3090 24GB约**$0.21/小时**。这解释了为什么很多中小团队在迁移或微调阶段会先选3090/4090做性价比验证,再上A100做规模训练。

结合前面的速度倍数,你可以得到一个直观结论:预算紧/模型中小→3090很省钱;需要稳定、多卡并行与较大显存→V100是务实之选;追求最快收敛/大模型→A100是首选;T4更像性价比高的推理/预处理卡。

典型业务场景选型建议(按“你要做的事”来)

- ResNet-50图像分类/检测、几千万张图片内:如果你是成本优先,单卡3090就能把吞吐量拉到可用水平;上量时用多卡同步,若考虑多机通信与稳定扩展,直接上A100/V100更省心。

- BERT/Transformer微调:A100对NLP训练速度提升显著(~2×),还能靠80GB显存更稳地上大batch;V100作为备选依然靠谱。3090在NLP上会比卷积更吃力。

- 在线推理与多实例隔离:T4的70W功耗与多精度推理性能适合大规模部署,A100的MIG则能在一张卡上切成多个隔离实例,一边训练一边做实验。

- 多卡并行/集群训练:企业级卡(A100/V100/A6000)在多卡通信、P2P与软件栈上更稳,有利于线性扩展与更快的“时间到可用模型”。

Hostease如何帮你快速落地

我们提供美国/香港/新加坡/韩国/日本等多地域GPU服务器与站群服务器产品:

- 就近部署:跨境独立站可按目标市场选择近源机房,降低训练数据拉取与线上推理延迟。

- 弹性组合:同区域内可按需混搭A100/V100/T4/3090,先用3090做方案验证,再无缝切到A100扩容。

- 运维与成本优化:支持分时/包月组合、镜像一键还原,持续优化你的“训练速度/美元”。

需要按你的模型与预算做精确方案?把任务类型(CV/NLP)、数据规模、可接受时长、目标地区告诉我们,我们会给出分GPU型号的时间与成本估算表,并安排上云试跑。

常见FAQ(新手重点看这里)

Q:为什么我看到的TFLOPS很高,但训练并不快?

A:深度学习训练受内存带宽、batch、实现与通信影响,吞吐量比TFLOPS更能反映真实速度。Lambda的基准就以吞吐量为准。

Q:A100相比V100,训练时间大约能省多少?

A:NVIDIA与Lambda的公开数据给出~1.95×~2.5×的速度提升,训练时间可降到V100的40%~51%。

Q:T4能训练吗,和V100差多久?

A:能训练但更适合推理/轻量任务。

Q:3090适合做哪些训练?和工作站级A6000差多少?

A:卷积类任务单卡几乎持平(3090≈A6000),NLP训练A6000≈**1.34×**3090更快。预算有限的图像类项目,3090很香。

Q:价格性能比怎么看?

A:参考TensorDock的公开演示:A100在绝对速度上领先;每美元吞吐层面,24GB的3090/4090在小中型模型上更划算,超大模型仍推荐A100/H100。

Q:A100的MIG和TF32有什么用?

A:MIG能把一张A100划成多个隔离实例,方便多实验并发;TF32让你不改代码也能拿到更高的矩阵吞吐。

参考价目&选型小抄(随市场波动,仅作对比思路)

| GPU | 参考按小时价(示例) | 速度/美元要点 |

|---|---|---|

| A100 80GB | ~$1.63–$1.65/h | 原始速度最佳,适合大模型训练与稳定多卡扩展 |

| V100 32GB | ~$0.42/h | 老牌稳健,速度明显快于T4,在NLP/多卡更省心 |

| RTX3090 24GB | ~$0.21/h | 小中型任务训练速度/美元高,适合验证与迁移学习 |

| T4 16GB | — | 推理友好,训练收敛时间显著长于V100 |

注:价格按第三方平台公开页面示例,随时变动;请以下单时为准。我们可按你的预算提供Hostease多地域最低成本组合与迁移路径。

结论与行动建议

- 追求训练效率/大模型显存:上A100,时间成本最低,规模化最顺畅。

- 预算受限但要稳:V100是折中方案,比T4快一大截,生态成熟。

- 轻量训练/验证/小中型任务:3090性价比高;验证通过再平滑切到A100做最终训练。

- 推理为主、密集部署:T4最省电,或用A100的MIG做多实例。

如果你希望一周内把项目从“能跑”推进到“能上产线”,把你的任务类型、数据规模、目标地区和预算告诉我们。我们会基于Hostease在美国/新加坡/日本的GPU服务器,为你给出明确的训练时间倍数与成本测算表,并安排一套可回滚的迁移方案,帮助你以最低试错成本上线。