在所有实时AI应用中,流式语音识别是最典型、也最能反映GPU性能的场景之一。无论是智能客服、会议转写,还是车载语音交互,用户都期待系统能在200–500毫秒内给出响应。如果超过这个范围,交互体验就会明显变差。

业内常用的指标是实时因子RTF:RTF≤1代表“能跟上人说话的速度”。因此,我们选取流式ASR(Automatic Speech Recognition)作为评测对象,通过对比不同GPU型号在响应延迟、吞吐量和稳定性上的表现,帮助你更直观地理解GPU云的价值。

测试方法与场景设定

为了模拟真实业务,我们参考了NVIDIA官方的Riva/NIM和DeepStream基准测试:

- 应用场景:流式语音识别(英语Parakeet-CTC模型)+视频检测任务对比

- 负载模式:分片推理,chunk大小分别为160ms(低延迟)和960ms(高吞吐)

- 测量工具:Riva streaming客户端、Triton性能分析器、DeepStream端到端测试方法

- 评价指标:平均延迟、吞吐量(RTFX)、帧率(FPS)、尾部延迟p95/p99

这样设定的好处是:既能反映日常对话中的“即时响应”,又能覆盖视频流分析等“多路输入”的应用。

评测结果:延迟与并发的差异

在低延迟模式(chunk=160ms)下,不同GPU的表现差异明显:

| GPU | 最大并发流数 | 单流平均延迟(ms) | 并发64流时平均延迟(ms) | p99延迟(ms) | 吞吐量RTFX |

|---|---|---|---|---|---|

| H100 | 270 | 14 | 42 | 130 | 63.7 |

| A100 | 179 | 16 | 59 | 216 | 63.6 |

| L40 | 190 | 19 | 52(并发48时) | 130(并发48时) | 47.8 |

可以看到,H100在尾延迟控制上最稳定,A100表现紧随其后,而L40虽然定位较低,但在并发几十路时也能保持在50ms量级。

视频帧率对比:GPU云的直观优势

在视频任务上,DeepStream的测试结果更能体现“快到肉眼可见”的提升。以下为常见模型的端到端FPS表现:

| 模型/精度 | A100 | A30 | A10 | L4 | L40 | H100 |

|---|---|---|---|---|---|---|

| YOLOv8s/INT8 | 2593 | 1879 | 1465 | — | — | — |

| PeopleNet-ResNet34/INT8 | 4955 | 3127 | 2056 | 1580 | 4571 | 6831 |

这意味着,一张A100或H100显卡就能同时处理成百上千路视频流,特别适合智慧城市、视频监控、车载感知等高并发场景。

如何把纸面性能转化为上线SLA

很多人关心:数据漂亮,但能否在自己系统里复现?这里给你几条实用经验:

- 动态批处理+多实例并发:在Triton中开启

dynamic_batching,并控制排队时间,就能在不显著拉长延迟的前提下提升吞吐。 - chunk大小选择:160ms适合对话式场景,960ms适合大规模批量转写。可根据业务场景灰度切换。

- 尾延迟优先:平均延迟可能看起来很低,但真正决定用户体验的是p95和p99。

- 精度与性能平衡:INT8量化能显著加速,但要通过WER/mAP验证精度是否满足业务需求。

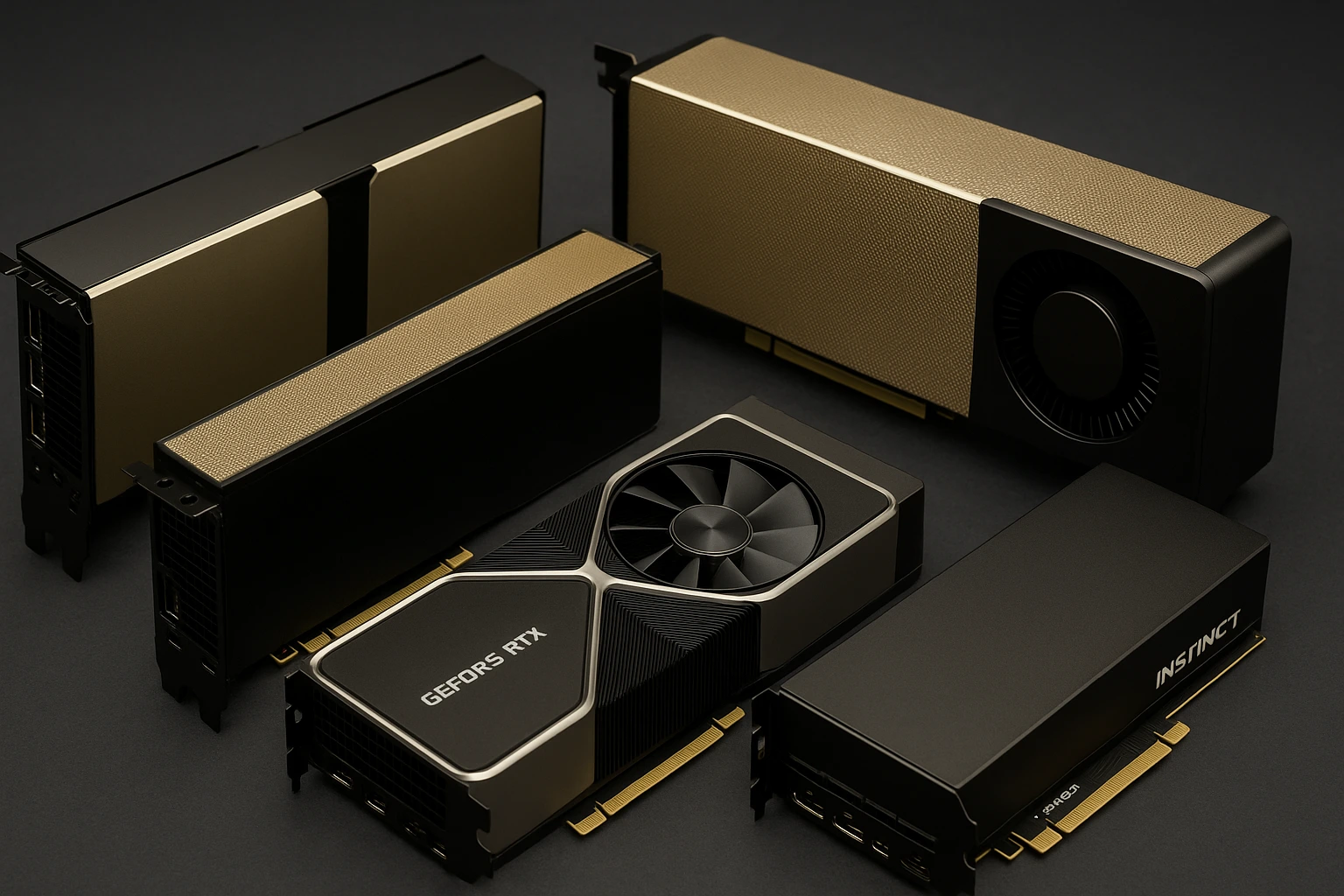

GPU云服务器的三种典型组合

- 客服语音/实时交互:选择L40/L4即可满足十几到数十路语音流的低延迟需求。

- 视频监控/多流分析:A100或L40在DeepStream环境下可支持千FPS级别吞吐,适合多路摄像头并发。

- 金融风控/自动驾驶仿真:对尾延迟极敏感的场景,优先考虑H100,以保证p99稳定性。

在Hostease的GPU云方案中,我们可以根据你的并发规模、SLA需求和预算,给出最优的GPU型号与部署组合,确保既高性能又具备成本效益。

常见问题FAQ

Q:怎么判断我的语音识别系统是否算“实时”?

A:看RTF是否≤1,同时确认响应延迟保持在200–500ms以内,并关注p95/p99。

Q:动态批处理会拖慢实时响应吗?

A:只要合理设置排队上限(如100µs),批处理可以提升吞吐而不明显增加延迟。

Q:DeepStream的FPS很高,但我自己跑不出来?

A:官方测试关闭了渲染,并启用了INT8+TensorRT优化。建议对齐这些配置再对比。

Q:一定要上H100吗?

A:不一定。如果不是极端低尾延迟或超大模型需求,L40或A100已经能覆盖大部分实时AI场景。

总结:GPU云是实时AI的“加速引擎”

从语音识别到视频分析,再到自动驾驶仿真,GPU云服务器带来的不仅是吞吐量的提升,更是延迟稳定性的保障。对于决策者而言,关键是结合业务SLA,选对GPU型号和优化策略。

如果你正考虑部署实时AI云服务器,不妨与Hostease联系,我们能为你提供就近机房、GPU型号推荐、Triton/Riva/DeepStream一键部署模板,让你快速验证性能,并真正落地业务。